Come contrastare il fenomeno dei Deepfake generati con l’AI

AI & DATA INNOVATION

Una delle applicazioni più in voga dell’AI (Artificial Intelligence) è la realizzazione di video modificati (Deepfake), in cui a personaggi famosi sono messe in bocca parole in realtà mai dette.

Una delle applicazioni più in voga dell’AI (Artificial Intelligence) è la realizzazione di video modificati (Deepfake), in cui a personaggi famosi sono messe in bocca parole in realtà mai dette. La tecnica sembra uscita direttamente dagli studi di Hollywood e quindi non stupisce nessuno: in “Forrest Gump”, film del 1994, l’attore Tom Hanks compare in un video storico insieme John F. Kennedy a cui sono modificati i movimenti delle labbra nel momento in cui i due si salutano. In altri casi, sempre per esigenze di produzione cinematografica (quando l’attore Paul Walker morì prima del termine delle riprese del film “Furious 7” del 2015, o per l’attore Oliver Reed nel film del 2000 “Il Gladiatore”) il viso e i relativi movimenti sono stati “inseriti” sul corpo di altre persone.

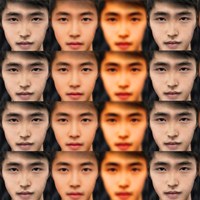

Il problema è che oggi la manipolazione dei video perché diventino dei “Deepfake” (termine che sta a indicare la confluenza tra deep learning e fakes, video che puntano a ingannare, disinformare) è alla portata di tutti, grazie a software avanzati basati su tecniche di intelligenza artificiale che cominciano a diffondersi in rete. E questo può innescare fenomeni di disinformazione e propaganda in grado di manipolare le coscienze di molte persone.

Il termine Deepfake viene coniato nel 2017, quando esplode il fenomeno della diffusione sui social di video pornografici con il viso sostituito con quello di celebrità. Dopo la condanna di questi comportamenti e la cancellazione dei video da parte delle principali piattaforme, l’attività “dilettantesca” di creazione di Deepfake si è quindi rivolta a politici e altri personaggi famosi, a cui sono state messe in bocca affermazioni non proprie. Virale il video di aprile 2018 in cui Barack Obama insulta il Presidente Trump: ma il video (come spiegato su BuzzFeed) è in realtà pensato per far capire quanto è diventata avanzata la tecnologia per l’audio e il video editing, e quali conseguenze negative può comportare per la vita democratica di una Nazione. Come spiegato nell’articolo su BuzzFeed, basta dotarsi della tecnologia giusta (nello specifico, FakeApp), di un po’ di capacità grafica, di un computer e di un po’ di tempo, e il “merge” tra due video diventa un gioco tra ragazzi. In questo modo, Obama parla e dice frasi che in realtà sono state pronunciate da un’altra persona.

C’è la possibilità di accorgersi che un video che stiamo ascoltando è in realtà un Deepfake?

Alcuni elementi possono aiutare: i movimenti della bocca ad esempio possono essere poco naturali, poiché è uno degli aspetti su cui agisce il software, ma è probabile che gli avanzamenti tecnologici andranno a migliorare sempre più la verosimiglianza. Secondo gli esperti in futuro saranno realizzate soluzioni (anche queste basate su intelligenza artificiale) per individuare i Deepfake, ma la loro diffusione non seguirà probabilmente le strade dei video amatoriali. Che nel frattempo non si arrestano: come è successo ad esempio con il video del finto Mark Zuckerberg che su Instagram afferma: “Imagine this for a second: one man with total control of billions of people’s stolen data, all their secrets, their lives, their futures. I owe it all to Spectre. Spectre showed me that whoever controls the data, controls the future.”

Nel frattempo però qualcosa si sta muovendo per decidere se i Deepfake possono comportare rischi gravi, e se – come nel caso delle fake news, e in generale di qualsiasi attività di disinformazione programmata e decisa a tavolino – non debbano essere sanzionati e bloccati.

Una direzione che sta valutando il Congresso americano è quella di obbligare i produttori di Deepfake a dichiarare (con un “bollino” ben riconoscibile) la natura di “falso” della propria creazione. Anche i social network potrebbero essere costretti da un’apposita legislazione a individuare video fasulli e quindi ad avvertire l’utente. Inoltre, si comincia a pensare a sanzioni e pene più gravi nel caso in cui la gravità del messaggio sia superiore, e ci sia chiaramente un intento denigratorio verso una persona. Ascoltati dal Congresso USA, un gruppo di esperti (tra cui professori dell’Università del Maryland, dell’Università di Buffalo e altri esperti in tema di AI e digital policy) ha elencato i diversi problemi presentati da contenuti fake prodotti con AI indicando alcune soluzioni per contrastarli, in un futuro definito di “post-truth”. Interessanti i risultati emersi nel complesso. Secondo gli esperti infatti:

- Non sarà facile fermare il diffondersi dei Deepfake e la legge potrà fare ben poco; serve un insieme di misure legali, di mercato, e soprattutto di “resilienza sociale”;

- Gli usi malevoli dei Deepfake possono essere molteplici, molti ancora non noti;

- Esiste la possibilità che questi video si diffondano a grandissima velocità, rendendo ancora più difficile l’azione di contrasto;

- Come nel caso di altri rischi, legati a estremismi e disinformazione, è necessario, soprattutto in vista delle elezioni del 2020, che ci sia un impegno diffuso nel collaborare e nel segnalare questi fenomeni. In particolare, deve esserci una cooperazione con i social media;

- Un effetto indiretto di questi come di altri usi scorretti e legati alla disinformazione è che nel lungo termine possono minare la credibilità che le persone ripongono nei Media.

A cura di:

Elena Vaciago, @evaciago